Nos objectifs

Autonomie Spatiale

Le cœur du projet SAM-Guide est de favoriser l'autonomie des personnes aveugles ou malvoyantes dans leurs interactions avec l’espace. Qu’il s’agisse de se déplacer dans un bâtiment, de retrouver un objet ou de pratiquer une activité physique, la perte de vision rend ces tâches complexes et parfois impossibles sans assistance. L’objectif est donc de développer des outils sensoriels intuitifs qui permettent à l’utilisateur de s’orienter, de se repérer et d’interagir avec son environnement sans dépendre d’une aide humaine ou d’un guidage visuel. Ces outils doivent leur offrir la liberté de se déplacer et d'agir de manière sécurisée, fluide, et autonome.

Transcodage Sensoriel

Une des ambitions majeures de SAM-Guide est de concevoir un langage sensoriel universel, capable de convertir les informations spatiales — habituellement transmises par la vision — en signaux tactiles et auditifs. Ce processus, appelé transcodage sensoriel, repose sur des principes issus des neurosciences, de la cognition spatiale et de l’ergonomie. Il s'agit de transmettre uniquement les informations essentielles, de manière intelligible et intuitive, tout en respectant les limites cognitives de l’utilisateur. L'objectif est de créer un système cohérent et modulaire, utilisable dans différentes situations et adaptable à diverses interfaces (ceinture, casque, etc.).

Technologies inclusives

SAM-Guide vise à concevoir des technologies réellement accessibles, pensées pour s’adapter aux besoins spécifiques des personnes aveugles ou malvoyantes. Le projet privilégie une approche inclusive : les dispositifs développés sont légers, portables, compatibles avec les déplacements urbains ou les activités sportives, et ne nécessitent pas un apprentissage complexe. L’idée est de sortir de la logique de substitution totale de la vision, pour proposer au contraire des outils concrets, simples, et facilement intégrables dans le quotidien. En améliorant leur accessibilité à des contextes variés, ces technologies participent à une société plus juste et inclusive.

Notre approche scientifique

- Étudier la perception spatiale

- Créer un langage sensoriel

- Tester en réalité augmentée

- Appliquer en conditions réelles

Les technologies mobilisées

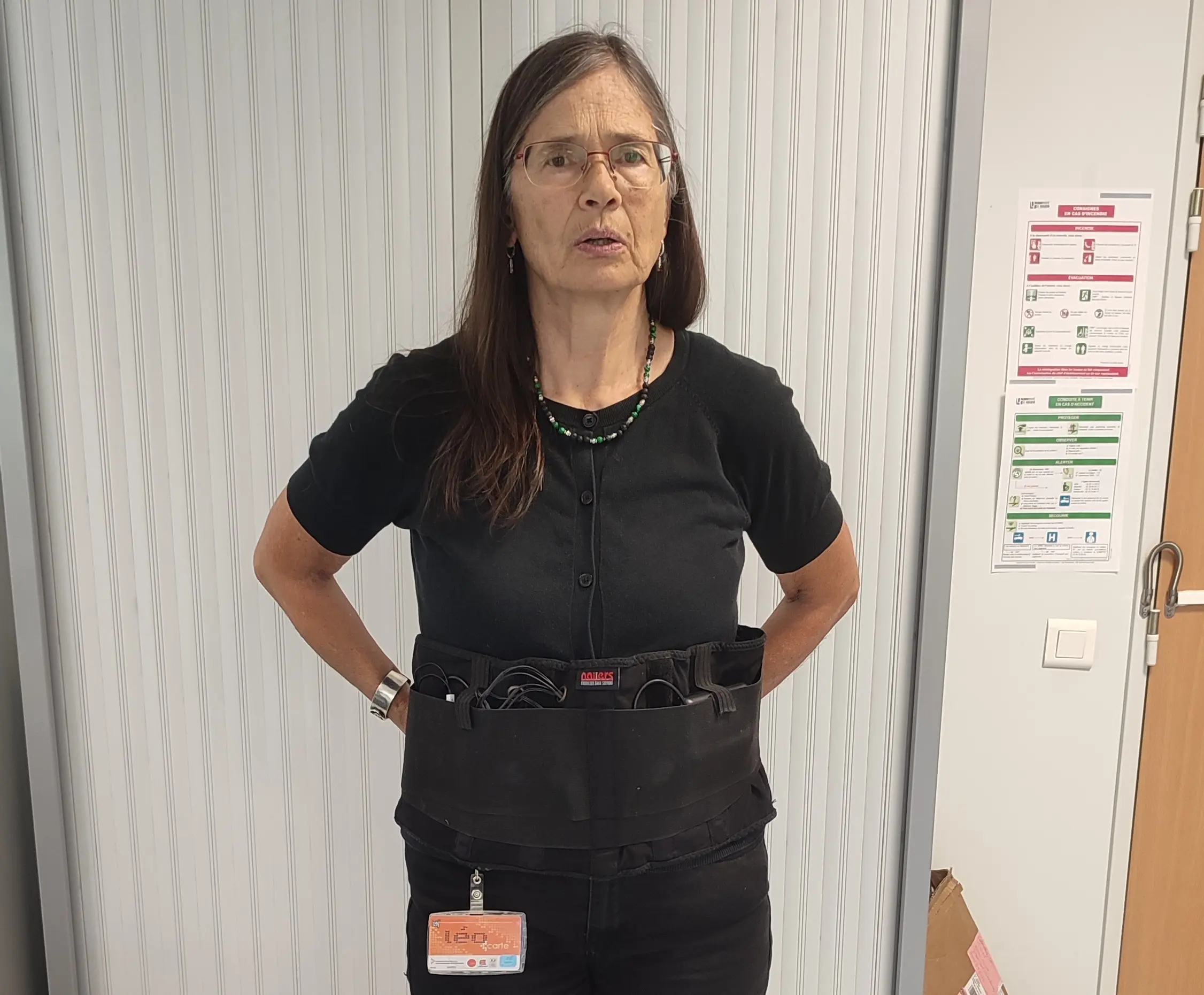

Ceinture Tactile

La ceinture vibratoire est un dispositif porté autour de la taille (voir images au dessus), équipé de plusieurs moteurs vibrants positionnés tout autour du corps. Chaque vibration est utilisée pour transmettre une information directionnelle : par exemple, une vibration à droite indique une direction vers la droite. Ce dispositif permet aux utilisateurs d’anticiper un virage ou de s’aligner sur un chemin, même en l’absence d’un repère visuel. L’usage de la ceinture permet de garder les mains libres et réduit la charge attentionnelle, ce qui la rend particulièrement utile dans les situations où la sécurité est primordiale.

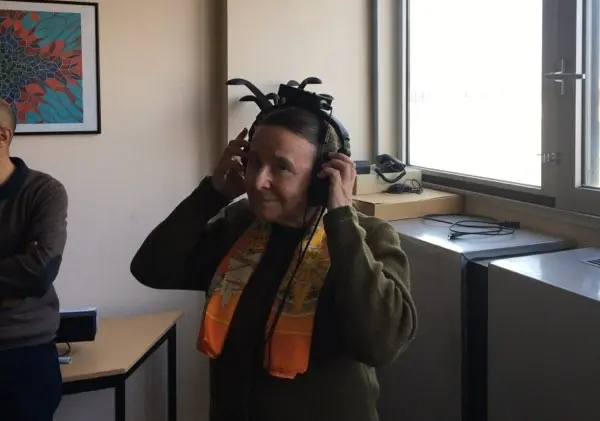

Guidage Sonore

SAM-Guide intègre une palette de signaux sonores complémentaires. Les sons spatialisés, produits à l’aide de traitements audio binauraux, permettent à l’utilisateur de localiser dans l’espace une cible ou un point de repère, en percevant le son comme venant d’une direction précise. Les sons non-spatialisés, plus neutres, servent à transmettre des informations comme des alertes, des retours d'action ou des consignes. Cette complémentarité enrichit l’expérience de navigation et facilite l’adaptation à différents environnements, qu’ils soient calmes ou dynamiques.

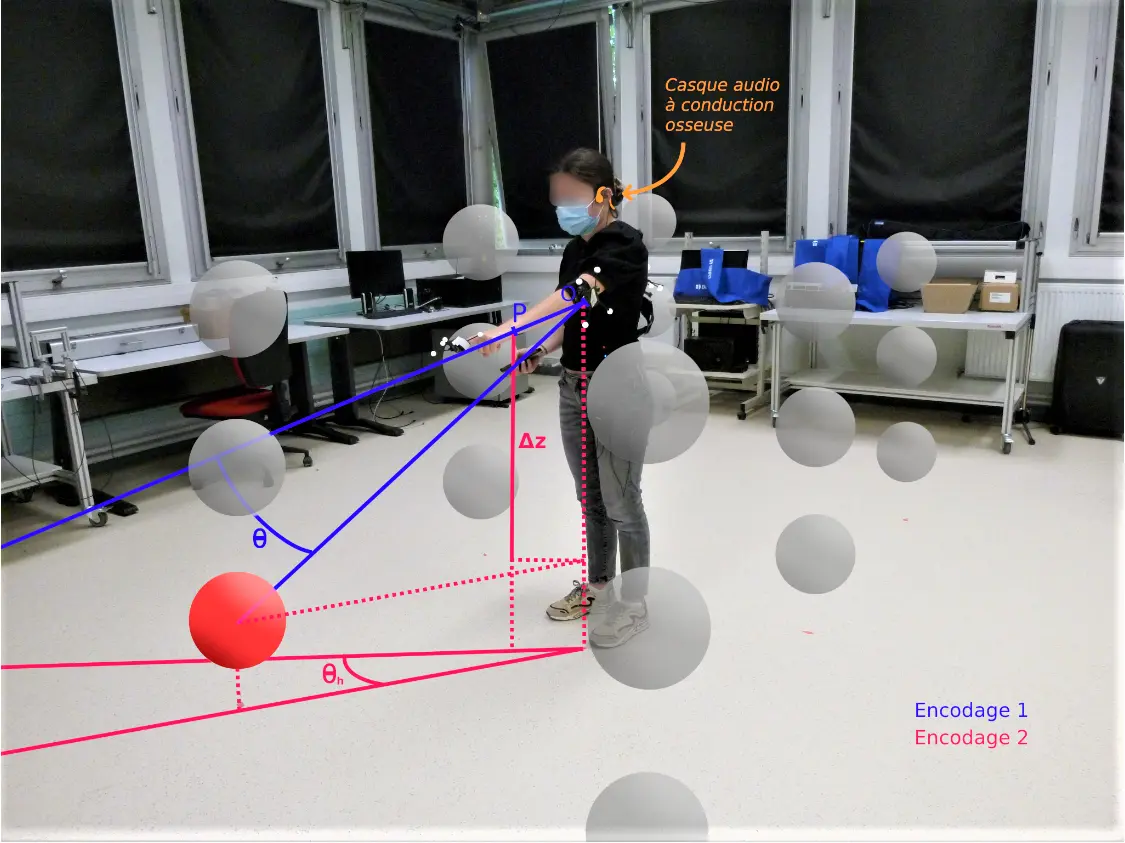

Systèmes de capture et réalité augmentée

Pour concevoir et tester les technologies, le projet utilise des environnements numériques enrichis et ajustés en temps réel à l’aide de systèmes de capture de mouvement. Cela permet de simuler des espaces complexes dans lesquels les utilisateurs peuvent être guidés et orientés grâce à des signaux sensoriels. La réalité augmentée permet de modéliser précisément l’environnement, de détecter les interactions, et d’adapter les signaux aux mouvements et à l’attention de l’utilisateur, afin d’optimiser la fluidité d’usage et de personnalisation.

L’avancée du projet

Les Applications Pratiques

Entraînement à la mobilité

Les dispositifs développés dans SAM-Guide peuvent être intégrés à des parcours de formation ou de rééducation, afin d’aider les personnes aveugles ou malvoyantes à apprendre ou renforcer leur capacité à se déplacer de manière autonome, aussi bien en intérieur qu’en extérieur.

Laser-Run

Le Laser-Run adapté est une application concrète du projet SAM-Guide. Il propose une mise en situation ludique et immersive pour tester les dispositifs dans un contexte dynamique. Grâce aux retours tactiles et aux sons (à la fois spatialisés pour l’orientation, et non-spatialisés pour les consignes ou alertes), les participants peuvent s’orienter, viser et se déplacer sans utiliser la vue. Ce format sportif permet d’évaluer l’efficacité des dispositifs dans des conditions proches de la réalité, tout en mettant en valeur leur potentiel inclusif.

Navigation urbaine assistée

À plus long terme, ces technologies pourront être adaptées à des systèmes de guidage pour la navigation en ville ou dans des lieux complexes (gares, hôpitaux, centres commerciaux), afin de renforcer l’autonomie au quotidien dans des environnements vastes et denses.

Publications scientifiques

-

Faugloire, E., Lejeune, L., Rivière, M.-A., & Mantel, B. (2022).

Spatiotemporal Influences on the Recognition of Two-dimensional Vibrotactile Patterns on the Abdomen.

Journal of Experimental Psychology: Applied, 28(3), 606–628.

https://doi.org/10.1037/xap0000404 (s'ouvre dans un nouvel onglet) -

Morice, A., Mantel, B. & Faugloire, E. (2022).

Assistance vibrotactile à l’interception locomotrice de cibles mobiles : étude de faisabilité.

56e congrès de la Société d’Ergonomie de Langue Française. : https://hal.science/hal-03759604/ (s'ouvre dans un nouvel onglet) -

Mantel, B. & Faugloire, E. (2022).

Conditions de l’incorporation d’un objet. Point de vue d’une approche incarnée de la perception

20e congrès de l’Association des Chercheurs en Activités Physiques et Sportives. : https://normandie-univ.hal.science/hal-04622055v1 (s'ouvre dans un nouvel onglet) -

Mantel, B. & Faugloire, E. (2023).

Perspective écologique sur la cognition incarnée.

20e congrès de l’Association des Chercheurs en Activités Physiques et Sportives. : https://hal.science/hal-04626303v1 (s'ouvre dans un nouvel onglet) -

Fons, Huet, Pellerin, Gerber, Graff (2023)

Moving Towards and Reaching a 3-d Target by Embodied Guidance: Parsimonious vs Explicit Sound Metaphors : https://hal.univ-grenoble-alpes.fr/hal-04192144 (s'ouvre dans un nouvel onglet) -

Fons, Huet, Pellerin, Graff (2024)

Using Fitts Law to Compare Sonification Guidance Methods for Target Reaching Without Vision : https://hal.univ-grenoble-alpes.fr/hal-04492351 (s'ouvre dans un nouvel onglet) -

Fons, Huet, Pellerin, Graff (2025)

Dissociate Dimensions to Improve Sound Metaphors Guiding the Hand Towards 3D Non-visible Targets : https://hal.science/hal-05034749v1 (s'ouvre dans un nouvel onglet)

Voir la liste : https://anr.hal.science/search/index/?q=%anrProjectReference_s:ANR-21-CE33-0011 (s'ouvre dans un nouvel onglet)

Posters